MIT人工智能实验室发力!让机器人告诉你5秒后的世界

这周MIT人工智能实验室在视觉预测领域取得突破性进展,让机器预测下一秒的世界。

面对握手、拥抱、kiss……,基于经验和直觉,我们总是能在动作完成之前给予对方正确的回应,那机器人可不可以做到呢?答案是可以的!

就在这周 ,MIT的计算机科学及人工智能实验室(CSAIL)的研究者们在视觉预测领域取得了一项突破性进展,使得预测交互行为算法的精确性得到了前所未有的提高。

在经过大量视频的情景训练后,他们研究的系统能够预测两个人是否会拥抱,接吻,握手或者击掌。下一阶段,它还能预测视频中5秒钟后会出现的对象。

“人类能够通过自身经验去自动学习行为预测,这也使我们对能否让计算机获得这种常识产生兴趣。”CSAIL的博士生Carl Vondrick说。对于研究团队的成果,Vondrick表示:“我们想要展示的是,仅仅通过观看大量视频,计算机就能获得足够的知识来连续预测其周围的环境。”

工作原理

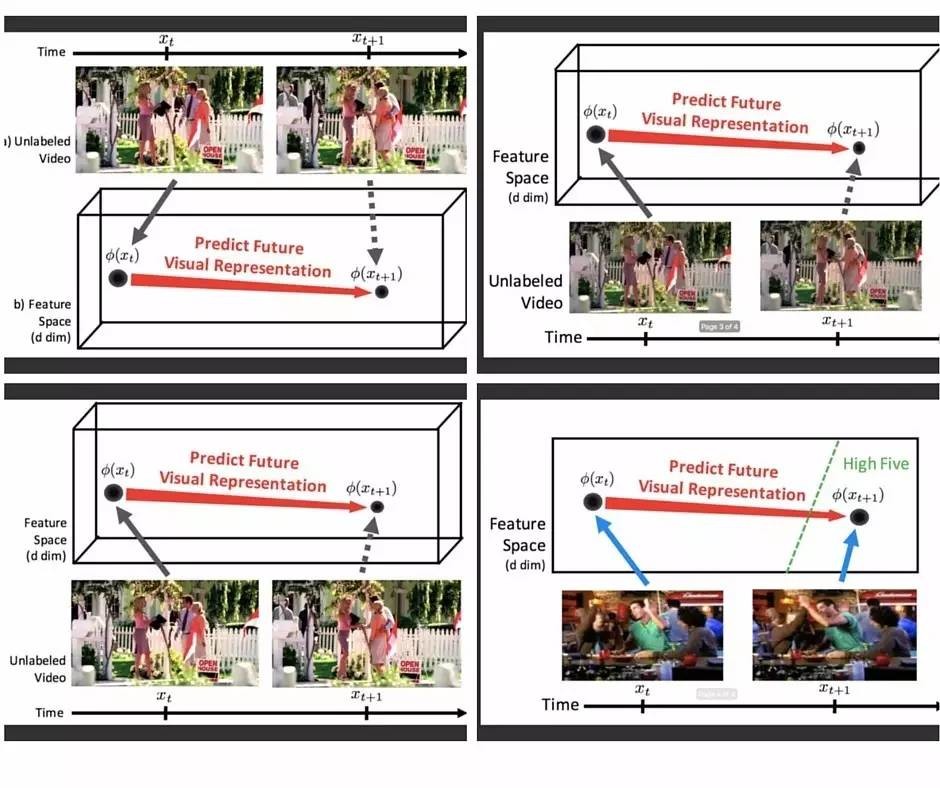

值得一提的是,在这次研究开发中,CSAIL团队并没有采取过往“预测型计算机视觉研究”中运用较为普遍的两种方法,而是自行开发出一种能够预测“视觉表征”的算法,该算法利用了深度学习技术(人工智能的一个分支),即运用“神经网络”系统来教计算机观察大量数据从而自动找出模型。

对于这种算法,Vondrick给出的解释是:“不是说一个像素值为蓝色,下个为红色,等等这样,视觉表征揭示了更大规模的图片的信息,比如某个人脸像素的采集。”

在具体的运作过程中,每一个预测表征的这种算法网络,都会被自动归类为四种行为(拥抱,握手,击掌或者kiss)之一,然后系统会融合所有行为于一体给出最终预测结果。例如,三个网络预测kiss,另一个可能是拥抱。

当被问到为何自行开发算法的时候,Vondrick表示:“未来有着天然的不确定性,所以去开发一个运用这些表征来预测所有可能性的系统带来的自我挑战非常令人兴奋。”

成果展现

在运用算法进行了600个小时无标签视频训练后,研究团队拿出一个新的视频来对此系统进行测试。

在视频中的人物离完成四种动作之一还有1秒钟的时候,系统的预测准确度达到了43%,比之前的测试结果高出了7个百分点。

文章一开始也说过,除了预测两个人的动作之外,这个算法还有一个目标——预测接下来5秒出现的对象。现在让我们来看看它所呈现的结果。

在第二项研究中,该算法展示了来自某个视频的框架,并预测5秒后会出现的物体。例如某人打开微波炉看见的是一个咖啡杯。对于该物体的预测结果,算法给出的预测准确性是测试基准的30%,尽管研究者们提醒说平均精确度只有11%。千万不要看不起这数值哦,毕竟根据测试,人类受试者的预测准确性也是能达到71%而已。

未来目标

虽然到目前为止,CSAIL团队开发的这种算法在实际运用中的预测还不够精确,但Vondrick还是很乐观的表达了自己的态度:“可能会出现一些重大进展,使我们离视觉预测在现实世界中的利用更近一些。”在他的未来展望中,此种算法的未来版本将能够用于所有事情,从制定更优行动计划的机器人,到发生人员跌落或伤亡时能够通知急救人员的安全相机。

最后,记得关注微信公众号:镁客网(im2maker),更多干货在等你!

硬科技产业媒体

关注技术驱动创新

人工智能

机器人

人工智能

机器人

微信ID:im2maker

微信ID:im2maker

长按识别二维码关注

长按识别二维码关注